In mei hebben we twee bootcamps gegeven over ontwerpen met kunstmatige intelligentie (AI). De bootcamps waren vooral gericht op docenten en onderwijsmakers die bezig zijn met ontwerp- of technologievakken. We hebben het gehad over de nieuwe tools die AI biedt en wat dit betekent voor het onderwijs. Zo is er gekeken naar hoe AI ingezet kan worden als onderwijsondersteuning, hoe leerlingen er verstandig mee om kunnen gaan en hoe we de leerlingen kunnen uitdagen als ze AI tools mogen gebruiken.

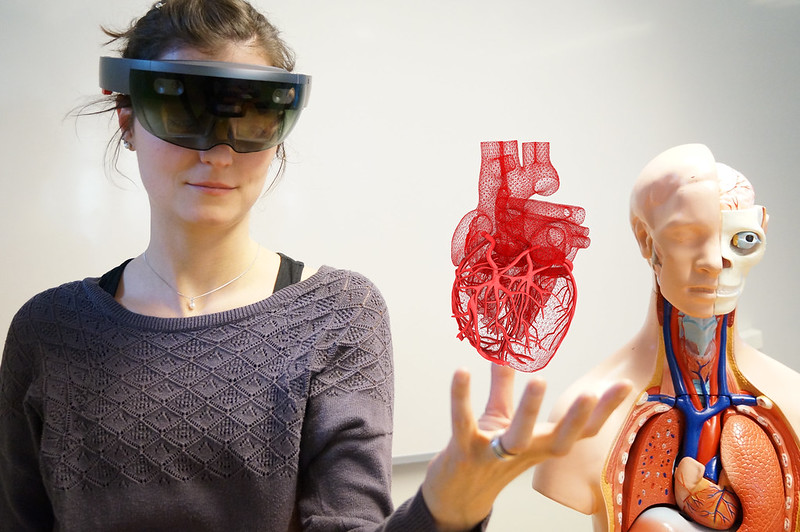

Hieronder zie je een aantal experimenten:

Tijdens de bootcamp zijn we met verschillende tools aan de slag gegaan om o.a. foto’s, logo’s, video’s, tekst, spraak en presentaties te genereren, bijvoorbeeld om ondersteund te worden in het schrijven van scripts voor e-learning of om samen met AI een afbeeldingen voor een boek te creëren in een specifieke stijl.

Nu de ontwikkelingen rondom AI zo snel gaan, is een bootcamp een goede mogelijkheid om er samen in te duiken om zo meer overzicht te krijgen. Naast dat AI heel veel nieuwe tools biedt, kan het voor ontwerpers die er niet genoeg van weten ook enigszins bedreigend voelen. Het is dus goed om samen over de toekomst van AI na te denken en tot antwoorden te komen. Hopelijk kunnen we leerlingen en studenten zo nog beter voorbereiden op de toekomst.

Zelf aan de slag?

Kijk hier of er al een nieuwe bootcamp met open inschrijving gepland staat.

Is dat niet het geval, of ben je op zoek naar een inhouse training? Laat ons vooral weten dat je geïnteresseerd bent via dit formulier. Dan laten we je weten wat er mogelijk is!